Open WebUI 使用

约 930 字大约 3 分钟

2025-02-07

Open WebUI 是一个可扩展、功能丰富且用户友好的自托管 AI 平台,旨在完全离线运行。它支持各种LLM运行器,如 Ollama 和 OpenAI 兼容的 API,并内置了 RAG 推理引擎,使其成为强大的 AI 部署解决方案。

使用

Docker中使用

提示 由于国内的镜像源现在好多都不行了,后面操作使用的代理。

搜索openwebui镜像

$ docker search open-webui

NAME DESCRIPTION STARS OFFICIAL

backplane/open-webui Automated (unofficial) Docker Hub mirror of … 6

dyrnq/open-webui ghcr.io/open-webui/open-webui 38

xuyangbo/open-webui open webui, a front end for LLM. https://git… 1

imroc/open-webui 0

qiruizheng/open-webui 0

0nemor3/open-webui 0

justmbert/open-webui 0

mbentley/open-webui 0

ag471782517/open-webui 0

saif233/open-webui 0

t9kpublic/open-webui 0

joeymartin77/open-webui 0

lukasthirdmind/open-webui 0

charnkanit/open-webui 0

wind520/open-webui ghcr.io/open-webui/open-webui 0

yoprogramo/open-webui open-webui compiled image 0

mars1128/open-webui 0

sfun/open-webui 0

nirmaaan/open-webui Deployment of Open WebUI on Azure 0

tribehealth/open-webui 0

dimaskiddo/open-webui Debian Based Open-WebUI Image Repository 0

openwrtclub/open-webui 0

girishoblv/open-webui 0

bean980310/open-webui 0

whatwewant/open-webui下载镜像

docker pull dyrnq/open-webui

Using default tag: latest

latest: Pulling from dyrnq/open-webui

4d2547c08499: Pull complete

93aa4e5d5dd6: Pull complete

1af95936e70e: Pull complete

030ad528ba70: Pull complete

ffca15c0b2b5: Pull complete

4f4fb700ef54: Pull complete

8e313df310c8: Pull complete

7aeddd66d1eb: Pull complete

a4d671c59575: Pull complete

79973909b43a: Pull complete

a9bbb08adf77: Pull complete

7298ee4f053d: Pull complete

d2f87ad13d61: Pull complete

d1fe9fe53d79: Pull complete

5577287d6500: Pull complete

Digest: sha256:fbe4e8219e0598d05a6c67340b573a9bbb7d6de493baecc5d8d1f2d75b43f206

Status: Downloaded newer image for dyrnq/open-webui:latest

docker.io/dyrnq/open-webui:latest

What's next:

View a summary of image vulnerabilities and recommendations → docker scout quickview dyrnq/open-webui启动容器

文档上使用docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main启动容器,但是我下载的镜像是dyrnq/open-webui,所以启动命令改为如下:

$ docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always dyrnq/open-webui:latest

4d323fdaef6b446abc10d14f6677e5da2fc4a83b5828d42e18c8e6c45982e65c本地访问http://localhost:3000,可以看到登录页面,点击之后就会让创建管理员账号(第一次访问的时候),创建成功后就可以使用了。

右上角可以切换模型,目前我本地只下载了deepseek-r1:1.5b的量化版本。

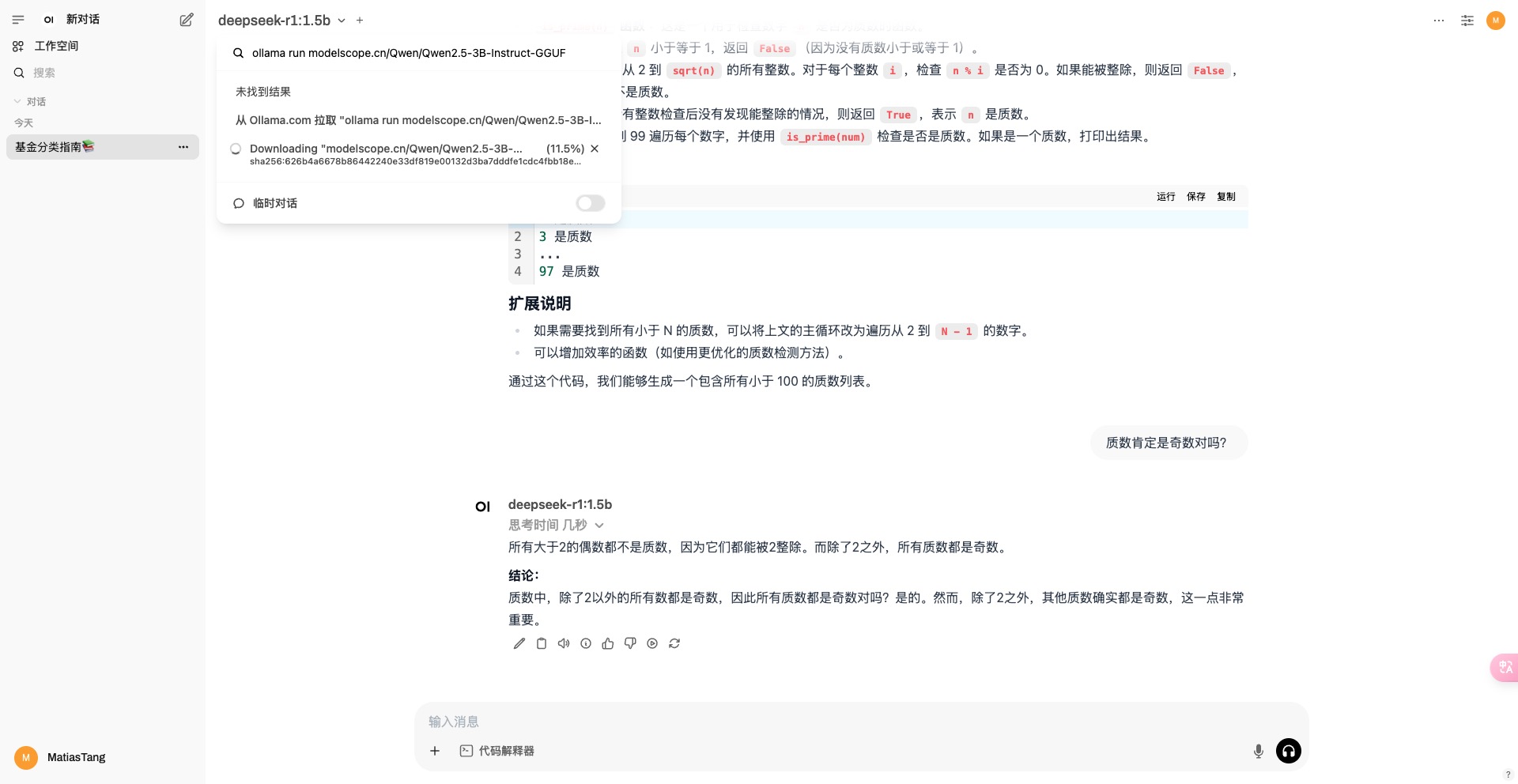

OpenWebUI中拉取模型

在OpenWebUI中拉取本地没有的模型很简单,只需要在模型的搜索框中,输入ollama run ****后,就可以在下拉框看到,是否通过ollama拉取模型。的提示,点击之后就开始拉取模型了。国内网络比较慢,建议优先使用modelscope中的模型。如下是ollama run modelscope.cn/Qwen/Qwen2.5-3B-Instruct-GGUF拉取的模型,默认是Q4_K_M版本。

Ollama加载ModelScope模型需要使用GGUF格式的模型,具体查看Ollama加载ModelScope模型

DeepSeek-R1硬件需求

DeepSeek-R1各版本硬件要求:

| 模型大小 | 参数量 | VRAM | RAM | 场景 |

|---|---|---|---|---|

| 1.5B | 15亿 | 2-4GB | 8GB | 针对边缘设备上的快速推理进行优化的轻量级版本 |

| 7B | 70亿 | 8-12GB | 16GB | 适用于通用推理任务的平衡模型 |

| 8B | 80亿 | 10-16GB | 16-32GB | 有更高的准确性和更好的上下文理解 |

| 14B | 140亿 | 16-24GB | 32GB | 推理和解决问题的能力得到提高 |

| 32B | 320亿 | 32-48GB | 64GB | 更强的逻辑分析和更精细的逐步输出 |

| 70B | 700亿 | 64GB+ | 128GB | 适用于高级人工智能驱动应用程序的高端版本 |

| 671B | 6710亿 | 多GPU(80GB+) | 256GB+ | 专家混合 (MoE) 模型,每个令牌激活 370 亿个参数,以实现最先进的推理性能 |

运行DeepSeek-R1的量化版本

使用Llama.cpp运行DeepSeek-R1的1.58量化版本